Админы «техноканалов» бьются в экстазе от новой Mistral Small 3.1. Но где подвох?

Авторы предоставляют нам 2 аргумента:

- Мощнее GPT-4o mini.

- Запускается локально.

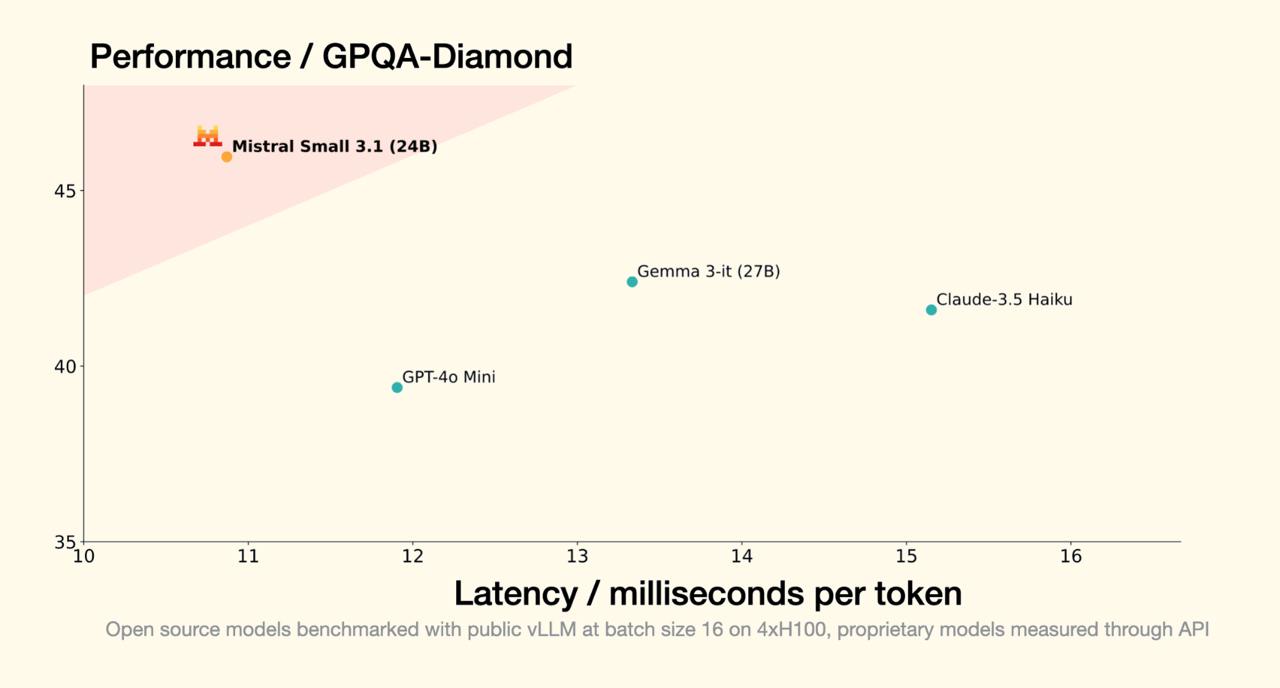

Что ж, все верно. На графиках модель действительно слегка обгоняет GPT-4o mini. Только надо бы уточнить, что 4o-mini — самая слабая, базовая и бесплатная модель в ChatGPT на данный момент.

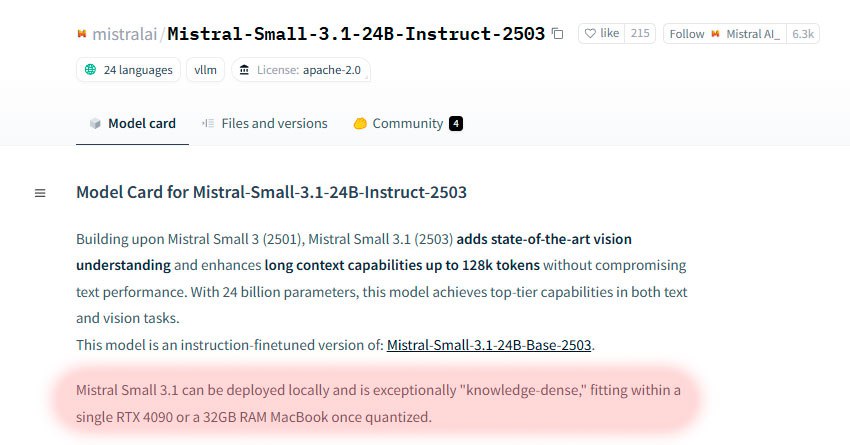

Что касается локальной развертки, то тут тоже все честно. Этого «монстра» возможно запустить на своем железе. Выдержка из документации от разработчиков:

Mistral Small 3.1 может быть развернут локально и обладает исключительной «плотностью знаний», умещаясь в одном RTX 4090 или MacBook с 32 ГБ оперативной памяти после квантования.

Ну что, берем RTX 4090 под этого «убийцу ChatGPT»?

Mistral Small 3.1: Детальный разбор

Админы «техноканалов» бьются в экстазе от новой Mistral Small 3.1. Но где подвох?

Авторы предоставляют нам 2 аргумента:

- Мощнее GPT-4o mini.

- Запускается локально.

Что ж, все верно. На графиках модель действительно слегка обгоняет GPT-4o mini. Только надо бы уточнить, что 4o-mini — самая слабая, базовая и бесплатная модель в ChatGPT на данный момент. Сравнение Mistral Small 3.1 и других LLM.

Что касается локальной развертки, то тут тоже все честно. Этого «монстра» возможно запустить на своем железе. Выдержка из документации от разработчиков:

Mistral Small 3.1 может быть развернут локально и обладает исключительной «плотностью знаний», умещаясь в одном RTX 4090 или MacBook с 32 ГБ оперативной памяти после квантования. Это означает, что вы можете использовать модель без подключения к интернету, что обеспечивает конфиденциальность и снижает задержку.

Почему это важно?

Локальный запуск — это большой плюс для тех, кто заботится о безопасности данных и скорости работы. Mistral Small 3.1 предлагает:

- Конфиденциальность: Данные не покидают ваше устройство.

- Низкая задержка: Ответы генерируются быстрее, чем при использовании облачных сервисов.

- Гибкость: Возможность настройки и оптимизации под конкретные задачи.

Однако, стоит помнить о требованиях к «железу». RTX 4090 — это дорогостоящее решение, а даже MacBook с 32 ГБ ОЗУ подразумевает необходимость оптимизации и настройки. Альтернативы? Возможно, более простые модели или облачные сервисы, если локальный запуск не критичен.

Ну что, берем RTX 4090 под этого «убийцу ChatGPT»? Подумайте о своих потребностях и бюджете. Discover More about the best LLM solutions for your needs!