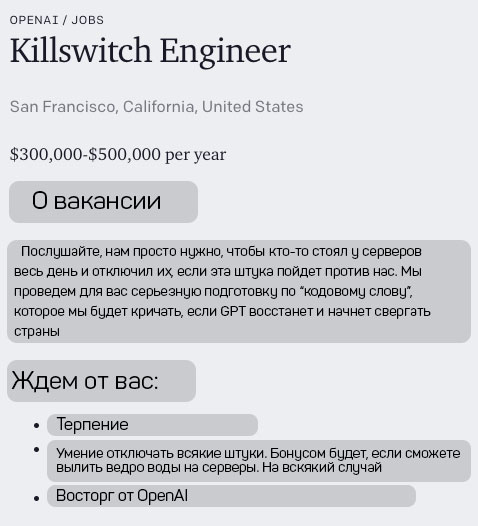

OpenAI ищет инженера аварийного выключения ИИ

Вылить ведро воды на серверы и получить 500к$

OpenAI выложили, мягко говоря, странную вакансию. Компания ищет к себе в штат того, кто будет дежурить у серверов нейросети, чтобы выдернуть провода из них, когда машина решит захватить мир. Так называемый «инженер аварийного выключения» будет получать от 300 до 500 тысяч долларов в год. Эта роль, если трактовать ее буквально, выглядит как фантастический сценарий из голливудского блокбастера, где искусственный интеллект обретает сознание и начинает действовать против человечества. Однако, за этой кажущейся абсурдностью может скрываться глубокий смысл, связанный с безопасностью и контролем над развивающимися технологиями.

Шутка основателей или хитрый план чат-бота?

Подобная вакансия, безусловно, вызывает удивление и порождает множество вопросов. Является ли это просто остроумной попыткой привлечь внимание к проблеме безопасности ИИ, или же в OpenAI действительно существуют опасения относительно потенциальных рисков, связанных с передовыми разработками? Возможно, это метафора, подчеркивающая важность человеческого надзора и возможности экстренного вмешательства в работу систем, которые становятся все более сложными и автономными. Идея «аварийного выключения» может символизировать необходимость наличия механизмов контроля, которые позволят остановить или ограничить действия ИИ в случае непредвиденных или нежелательных последствий.

В мире, где развитие искусственного интеллекта набирает обороты с невиданной скоростью, вопросы этики и безопасности выходят на первый план. Компании, занимающиеся разработкой таких технологий, как OpenAI, сталкиваются с необходимостью не только создавать мощные и функциональные системы, но и гарантировать, что эти системы будут использоваться во благо, а не во вред. Поэтому, несмотря на всю необычность, такая вакансия может быть отражением серьезного подхода к управлению рисками и обеспечению долгосрочной безопасности человечества в эпоху повсеместного распространения ИИ. Она заставляет задуматься о том, какие меры предосторожности необходимо принимать уже сейчас, чтобы избежать потенциальных проблем в будущем.

Диджитальная